tg-me.com/ds_interview_lib/864

Last Update:

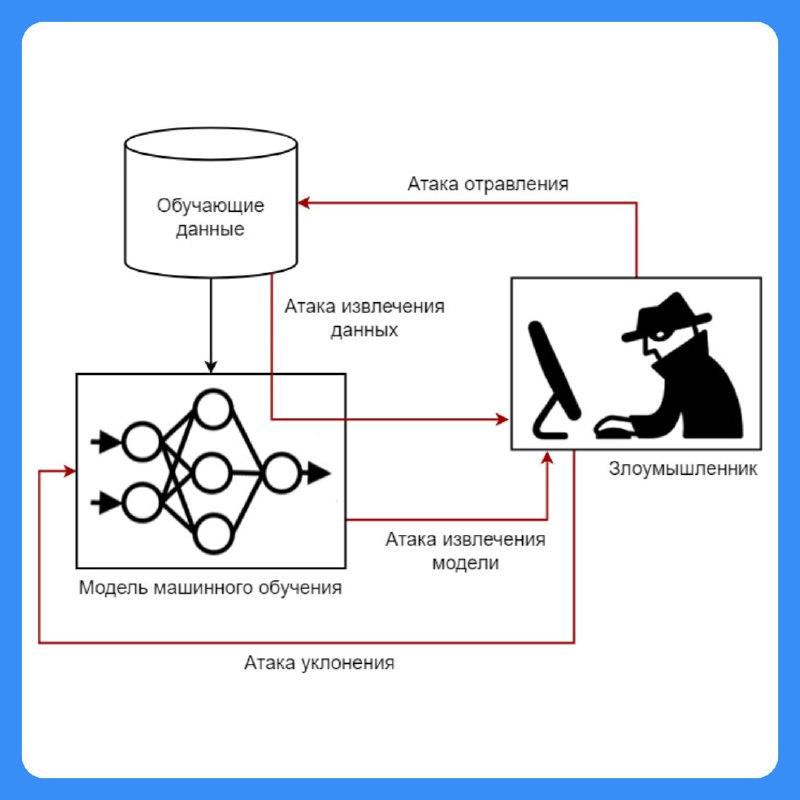

Какие существуют атаки на модели машинного обучения?

🔹 Атаки с изменением входных данных (Adversarial Attacks) — небольшие изменения в данных, которые заставляют модель ошибаться (например, изменение пикселей на изображении может заставить нейросеть принять панду за гиббона).

🔹 Атаки с отравлением данных (Data Poisoning) — внесение вредоносных примеров в обучающий набор, чтобы модель училась неправильно.

🔹 Извлечение модели (Model Extraction) — злоумышленник создаёт копию вашей модели, отправляя ей множество запросов и анализируя ответы.

🔹 Атаки на конфиденциальность (Membership Inference) — попытка определить, использовались ли конкретные данные в обучении модели, что угрожает приватности пользователей.

BY Библиотека собеса по Data Science | вопросы с собеседований

Share with your friend now:

tg-me.com/ds_interview_lib/864